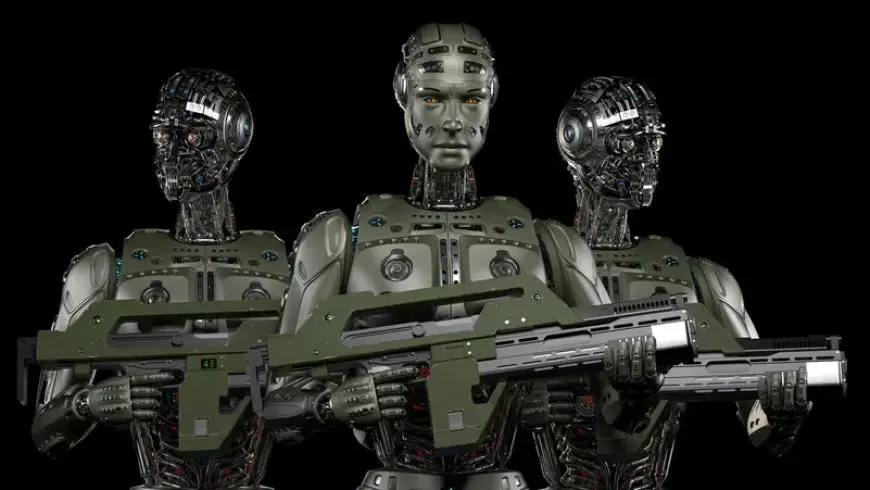

تحولات الذكاء الاصطناعي.. كيف يمكن أن يغير «تشات بي.آي.تي» موازين القوى العسكرية؟

تستخدم المؤسسات البحثية الرائدة التي لها علاقات بجيش التحرير الشعبي نموذج “اللاما” المفتوح من شركة ميتا لتطوير أداة ذكاء اصطناعي يمكن استخدامها في التطبيقات العسكرية، حسبما أفادت ثلاث أوراق أكاديمية ومحللون.

وفي بحث نُشر في يونيو/حزيران، قدم ستة باحثين صينيين من ثلاث مؤسسات، بما في ذلك اثنتين من أكاديمية العلوم العسكرية، تفاصيل حول استخدام نسخة مبكرة من لاما كأساس لما يسمونه “Chat BIT”.

اعتمد الباحثون على نموذج لغة سابق من Llama 13B وقاموا بدمج معاييرهم الخاصة لإنشاء أداة ذكاء اصطناعي تركز على الجيش تهدف إلى جمع المعلومات ومعالجتها وتوفير بيانات دقيقة وموثوقة لدعم اتخاذ القرار أثناء العمليات.

ووجدت الدراسة أنه تم تحسين برنامج “Chat BIT” لأداء مهام الحوار والإجابة على الأسئلة في المجال العسكري، وتبين أنه تفوق على بعض نماذج الذكاء الاصطناعي الأخرى، مثل برنامج “Chat GPT-4” التابع لـ Open AI وصلت دقة الأداء إلى حوالي 90%. ومع ذلك، لم يوضح الباحثون كيفية تقييم الأداء ولم يحددوا ما إذا كان النموذج قد تم تطبيقه في سياق عملي.

وقال صني تشيونغ، زميل مؤسسة جيمس تاون والمتخصص في التقنيات الناشئة في الصين، إن هذه هي المرة الأولى التي تشير فيها الأدلة إلى أن الخبراء العسكريين الصينيين يحاولون بشكل منهجي استخدام نماذج لغوية كبيرة مفتوحة المصدر، خاصة تلك التي أنشأتها شركة ميتا لاستخدامها في الأغراض العسكرية.

يسمح Meta بالاستخدام المفتوح للعديد من نماذج الذكاء الاصطناعي، بما في ذلك Llama، لكنه يفرض قيودًا تشمل ضرورة الحصول على ترخيص للاستخدام من خلال الخدمات التي تضم أكثر من 700 مليون مستخدم، وتحظر شروط الاستخدام أي استخدام عسكري أو حربي أو نووي أو عسكري. … التجسس.

ومع ذلك، نظرًا لانفتاح النماذج الوصفية، تواجه الشركة صعوبة في تطبيق هذه الشروط بشكل فعال.

وفي ردها على استفسارات رويترز أشارت ميتا إلى سياسة الاستخدام المقبول لديها وأكدت أنها اتخذت إجراءات لمنع إساءة الاستخدام.

وقالت مولي مونتغمري، مديرة السياسة العامة في الشركة: “أي استخدام لنماذجنا من قبل جيش التحرير الشعبي غير مسموح به وهذا ينتهك سياسات الاستخدام المقبولة لدينا”.